Spark (0) 安裝 Standalone Spark

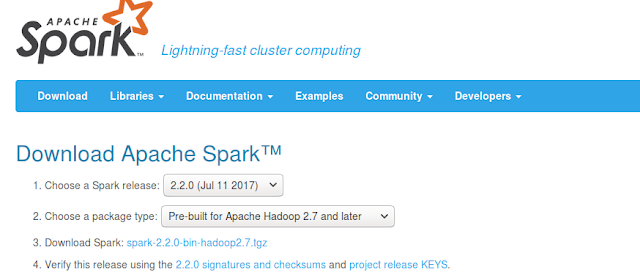

1. 下載 Spark:

到官網下載 Spark:

好了就解壓縮到你喜歡的地方,例如 HOME。

2. 在 .bashrc 設定 Spark 相關的環境變數:

#[start-20171205-CooperBear(Spark)-add]# export SPARK_HOME=/home/CooperBear/spark-2.2.0-bin-hadoop2.7 export PATH=$PATH:$SPARK_HOME/bin export PYSPARK_PYTHON=python3 #[end-20171205-CooperBear(Spark)-add]#

好了就 source 一下:

$source ~/.bashrc

測試看看 pyspark 是否正常:

$pyspark

pyspark 是在 $SPARK_HOME/bin 裡面,如果到這一步都正確的話應該會出現下面的畫面:

注意 python 的版本號要是 3.X

3. pip install pyspark package:

最後的最後為了讓我們的 python 能夠執行 spark standalone app 還需要 install pyspark package,之後會再解釋為什麼需要這個套件:

$pip3 install pyspark

留言

張貼留言